比肩LLama 2? Google发布了开源的AI小模型Gemma

今天, Google发布了开源的小模型Gemma.

Gemma使用的是与Google的商业Gemini大模型相同的技术, 但专注于小模型. 有意思的是, gemma这个名称来自于拉丁语, 意为“precious stone”, 中文是”宝石“

Gemma包括两个大小的模型, 分别是Gemma 2B与Gemma 7B, 每个模型又包括基础模型及指令微调模型

Gemma 2B与Gemma 7B

Gemma 2B与Gemma 7B都属于小模型行列, 小模型的优势在于普通个人只要有显卡, 你就能在本地把它跑起来并使用它, 而不需要太多的资源需求.

2B就是20亿参数, 7B就是70亿参数. 它们都属于小模型的行列, 如果不理解, 可以对比下Meta开源的Llama 2最高是70B, 也就是700亿参数

Gemma 7B适应于消费级显卡, 也就是4090这一类的消费级显卡就能把它跑起来. 而Gemma 2B则对硬件的要求更低, 适应于CPU或移动设备

Gemma 2B与Gemma 7B都包括两个版本, 基础模型与指令微调模型. 一般我们使用的与AI聊天, 就属于指令微调模型. 指令微调模型经过优化, 能更好的回答用户的问题, 与用户聊天等.

性能表现

每个模型发布, 最喜欢做的一件事就是展现自己的性能评分. Gemma也不例外.

根据Gemma自己提供的数据, 虽然属于小模型, 但分数及性能表现非常好. 参照如下图:

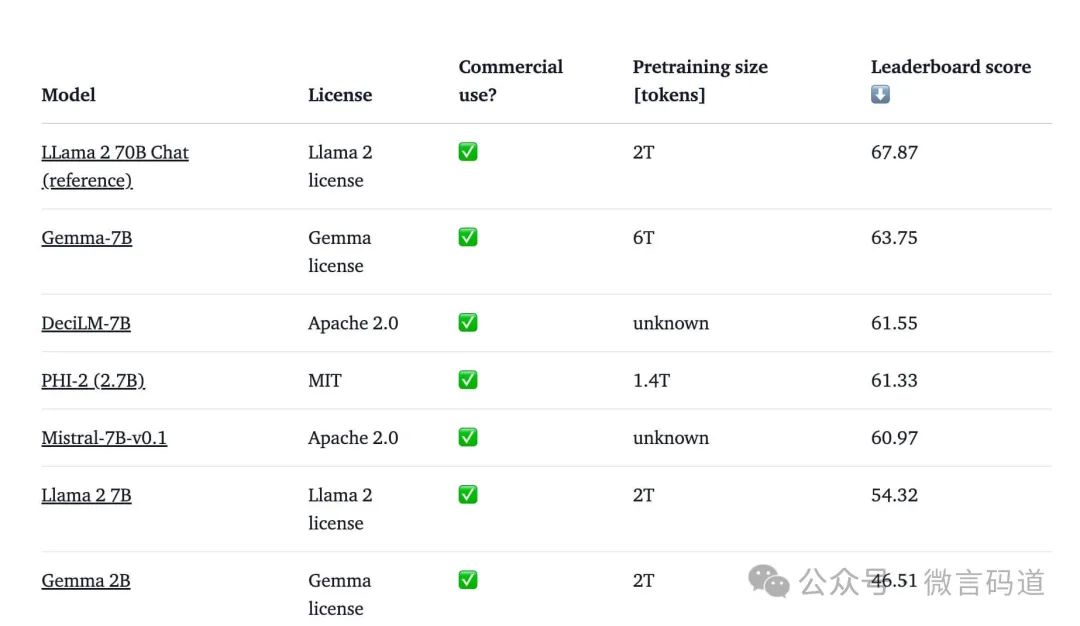

通过这个性能评分表来看, 在以LLama 2 70B做为基准来评分, 可以看到:

- Gemma-7B的性能表现非常优秀, 在仅1/10的模型参数大小的前提下, 表现只是稍弱于Lllam2 70B

- Gemma 2B的评分虽然最差, 但考虑到它的模型大小, 也算值得称道的

- 可以看出, 对于小模型, 微软的PHI-2表现最为优秀. 比Gemma 2B好很多

当然, 官方也提及, 这个性能表现不是针对聊天类, 而是评估基础模型的性能的. 但现在大多数使用AI, 都是聊天为主, 所以聊天类的性能表现, 暂时还没有看到官方提供.

关于小模型, 就不得不提及到微软的PHI-2了, 从上面的性能表现上也可以看出, PHI-2参数为27亿, 但表现却非常优秀. 如果要关注小模型, PHI-2是个不能错过的模型.

运行Gemma

官方的示例中使用了transformers来运行Gemma.

不过实际上, 使用本地模型, 我们大多会使用诸如ollama, vllm这一类的第三方工具来, 更简单方便.

在查阅了ollma官网中支持的模型列表后, 发现Gemma已经被支持了. 建议使用ollama来跑更快.

- 确保ollama版本

ollama最新版本是0.1.26. 之前的版本运行Gemma会报错

ollama -v

#应该显示 ollama version is 0.1.26- 运行Gemma模型

#默认是2b

ollama run gemma

#运行7B

ollama run gemma:7b- 通过API与gemma聊天

ollama支持命令行下直接和模型聊天, 也支持通过API与它交互. 这个API与OpenAI是几乎一致的.

curl http://localhost:11434/api/chat -d '{

"model": "gemma",

"stream": false,

"messages": [

{

"role": "user",

"content": "你好,你是谁"

}

]

}'最后, 模型回复了

{

"model": "gemma",

"created_at": "2024-02-22T03:01:10.980044Z",

"message": {

"role": "assistant",

"content": "你好!我是大自然语言模型,这是一个人工智能系统。我是一个大型语言模型,可以理解和生成多种语言形式的文本。\n\n请问您有什么可以帮助您的内容吗?"

}

}

体验下来, 虽然是2B, 但效果确实还可以. 也支持中文.

最后

随着AI的发展, 不仅是开源AI越来越成熟. 开源的小模型也越来越多, 效果越来越优秀.

如果你期望在本地搭建一个AI, 而不是使用在线的诸如OpenAI或文心一言等, 现在其实已经有非常多的选择了.

国内也有非常好的选择, 主要是:

- Qwen模型

- YI模型

国外的就更多了.

小模型除了Google的Gemma之外, 还有一个微软的PHI也非常值得关注, 相比下来更优秀. 另外Qwen的小模型, 比如1.5B, 4B其性能表现也很出色, 后续我再慢慢来聊一聊它们.