史上最全 | 室外大规模3D检测数据集汇总

史上最全 | 室外大规模3D检测数据集汇总

1、KITTI数据集

年份:2012年;

作者:Karlsruhe Institute of Technology and Toyota Technological Institute at Chicago;

场景数:约50个,室外场景;

类别数:共9类,分别是Car,Van,Truck,Pedestrian,Person_sitting,Cyclist,Tram,Misc,DontCare;

是否360°采集:否;

数据总量:包括7481张训练集,7518张测试集,以及其对应的点云数据;

标注总数:约200,000个3D标注框;

传感器型号:GPS/IMU型号为OXTS RT 3003,激光雷达型号为Velodyne HDL-64E,灰度相机型号为FL2-14S3M-C,彩色相机型号为FL2-14S3C-C,激光雷达的频率为10帧/秒,每次循环大约捕捉100,000个点,相机快门时间最快2ms,且使用激光雷达触发相机拍摄,因此相机频率与激光雷达频率持平;

数据集链接:https://www.cvlibs.net/datasets/kitti/index.php;

简介:KITTI是自动驾驶领域最重要的数据集之一,提供了大量的真实场景数据,用来更好的度量和测试算法的表现。除3D目标检测外,KITTI数据集还可用于评测立体图像,光流,视觉测距,3D跟踪等计算机视觉技术在车载环境下的性能。每张图像中最多达15辆车和30个行人目标,同时包含了各种程度的遮挡与截断。

2、nuScenes数据集

年份:2019年;

作者:nuTonomy;

场景数:约1000个场景,室外场景,采集自Boston和Singapore;

类别数:共23类,包括Car,Pedestrian,Bus,Bicycle等;

是否360°采集:是;

数据总量:包括40,000张图像数据,及其对应的点云数据;

标注总数:约1400,000个3D标注框;

传感器型号:共配备了6个相机型号为Basler acA1600-60gc,分辨率均为1600x900,除了背面的相机FOV为110°,其他的5个相机的FOV为70°,前置相机和侧面相机的视野中线角度为55度,相机采集速率为12Hz,使用了一个32线的LiDAR,型号为Velodyne HDL32E,采集频率为20Hz,还配置了5个Radar型号为Continental ARS 408-21,以及一个GPS/IMU型号为Advanced Navigation Spatial;

数据集链接:https://www.nuscenes.org/nuscenes#overview;

简介:nuScenes是自动驾驶领域最重要的数据集之一,相比KITTI数据集,nuScenes规模更大,同时记录了雷达数据(采集自Radar)。数据集由1000个场景组成,每个场景长度为20秒。在每一个场景中,有40个关键帧,也就是每秒有2个关键帧,其他的帧为sweeps。关键帧经过手工的标注,每一帧中都包含若干个annotation,标注的形式为bounding box,不仅标注了大小、范围、还有类别、可见程度等。这个数据集在样本的数量上、标注的形式上都非常好,记录了车的自身运动轨迹(相对于全局坐标),包含了非常多的传感器,可以用来实现更加智慧的识别算法和感知融合算法。

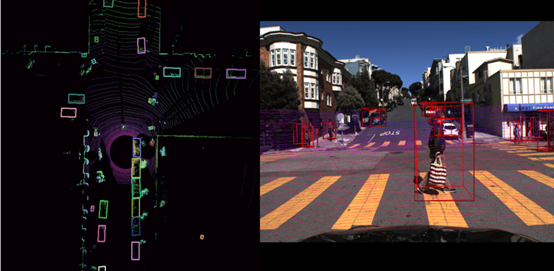

3、Waymo数据集

年份:2020年;

作者:Waymo LLC和Google LLC

场景数:共1150个场景,主要采集自San Francisco,Mountain View,Phoenix等;

类别数:共4类,分别是Vehicles,Pedestrians,Cyclists及Signs;

是否360°采集:是;

数据总量:共包含 2030个片段,每个片段长度为20秒;

标注总数:约12,600,000个3D标注框;

传感器型号:包含1个mid-range LiDAR,4个short-range LiDARs,5个相机(前置及侧面),同时LiDAR和相机是经过同步和标定处理过的;

数据集链接:https://waymo.com/open/;

简介:Waymo是自动驾驶领域最重要的数据集之一,规模很大,主要用以支持自动驾驶感知技术的研究。Waymo主要由两个数据集组成,Perception Dataset及Motion Dataset。其中,Perception Dataset包含3D标注,2D全景分割标注,关键点标注,3D语义分割标注等。Motion Dataset主要用于交互任务的研究,共包含103,354个20s片段,标注了不同物体及对应的3D地图数据。

4、Lyft L5数据集

年份:2019年;

作者:Woven Planet Holdings;

场景数:共1805个场景,室外;

类别数:共9类,包括Car,Pedestrian,traffic lights等;

是否360°采集:是;

数据总量:包括46,000张图像数据,及其对应的点云数据;

标注总数:约1300,000个3D标注框;

传感器型号:包括2个LiDARs,分别是40线和64线,安装在车顶及保险杠上,其分辨率为0.2°,在10Hz下采集约216,000个点。此外,还包括6个360°相机和1个长焦相机,摄像机与LiDAR采集频率一致。

数据集链接:https://level-5.global/data/;

简介:Lyft L5是一整套L5级自动驾驶数据集,据称“业内最大的自动驾驶公共数据集”,涵盖了Prediction Dataset及Perception Dataset。其中Prediction Dataset涵盖了自动驾驶测车队在Palo Alto沿线遇到的各类目标,如Cars,Cyclists和Pedestrians。Perception Dataset则涵盖了自动驾驶车队装置的LiDARs和摄像机采集的真实数据,并通过人工方式标注了大量的3D边界框。

5、H3D数据集

年份:2019年;

作者:Honda Research Institute;

场景数:共160个场景,室外;

类别数:共8类;

是否360°采集:否;

数据总量:包括27,000张图像数据,及其对应的点云数据;

标注总数:约1100,000个3D标注框;

传感器型号:共配备了3个相机型号为Grasshopper 3,分辨率均为1920x1200,除了背面的相机FOV为80°,其他的2个相机的FOV为90°,使用了一个64线的LiDAR,型号为Velodyne HDL64E S2,以及一个GNSS+IMU型号为ADMA-G;

数据集链接:http://usa.honda-ri.com/H3D;

简介:本田研究所于2019年3月发布其无人驾驶方向数据集H3D。该数据集使用3D LiDAR扫描仪收集的包括3D多目标检测和跟踪数据,包含160个拥挤且高度互动的交通场景,在27,721帧中有超过100万个标记实例。

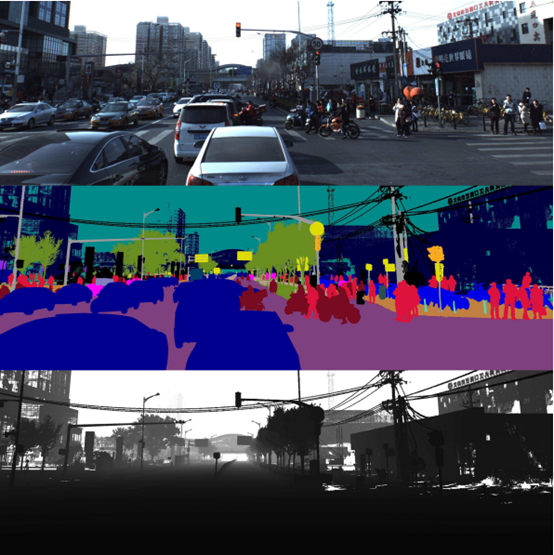

6、ApplloScape数据集

年份:2019年;

作者:Baidu Research;

场景数:共103个场景,室外;

类别数:共26类,包括small vehicles,big vehicles,pedestrian,motorcyclist等;

是否360°采集:否;

数据总量:包括143,906张图像数据,及其对应的点云数据;

标注总数:标注总数未知;

传感器型号:共配置了2个VUX-1HA laser scanners,6个VMX-CS6相机(其中两个前置相机分辨率为3384x2710),还有一个IMU/GNSS设备;laser scanners利用两束激光来扫描其周围环境,与常用的Velodyne HDL64E相比,scanner可以获得更高密度的点云,同时具备更高精度(5mm/3mm);

数据集链接:http://apolloscape.auto/index.html;

简介:ApolloScape由RGB视频和对应的稠密点云组成。包含超过140K张图片,并且每张图片都有像素级的语义信息。在国内采集的数据,所以相比于国外的一些数据集,ApolloScape数据集包含的交通场景较复杂,各类目标数量较多,且与KITTI数据集类似,同样包含Easy,Moderate,Hard三个子集。

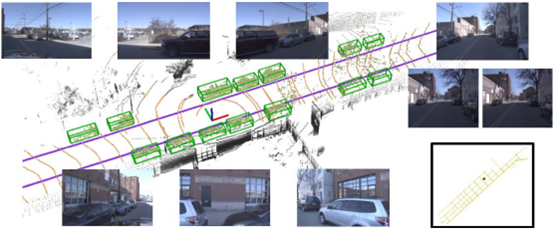

7、Argoverse数据集

年份:2019年;

作者:Argo AI等;

场景数:共113个场景,室外,包括USA,Pennsylvania,Miami,Florida等;

类别数:共15类,包括Vehicle,Pedestrian,Stroller,Animal等;

是否360°采集:是;

数据总量:包括44,000张图像数据,及其对应的点云数据;

标注总数:约993,000个3D标注框;

传感器型号:与KITTI及nuScenes相似,Argoverse数据集配置了两个32线LiDAR传感器,型号为VLP-32。同时,包括7个高分辨率环视相机,分辨率为1920x1200,2个前置相机,分辨率为2056x2464;

数据集链接:https://www.argoverse.org/;

简介:Argoverse中的数据来自Argo AI的自动驾驶测试车辆在迈阿密和匹兹堡(这两个美国城市面临不同的城市驾驶挑战和当地驾驶习惯)运行的地区的子集。包括跨不同季节,天气条件和一天中不同时间的传感器数据或“日志段”的记录,以提供广泛的实际驾驶场景。其包含了共113个场景的3D跟踪注释,每个片段长度为15-30秒,共计包含11052个跟踪目标。其中,70%的标注对象为车辆,其余对象为行人、自行车、摩托车等;此外,Argoverse包含高清地图数据,主要囊括匹兹堡和迈阿密290公里的车道地图,如位置、连接、交通信号、海拔等信息。

8、Matterport3D数据集

年份:2017年;

作者:Princeton University,Stanford University等;

场景数:共90个建筑物,室内场景;

数据总量:共194,400张RGB-D图像,10,800个全景图像,24,727,520个纹理三角面;

传感器型号:Matterport的数据获取,使用了三脚架固定的相机设备,有3个彩色相机和3个深度相机,分布在上中下。对于每个全景,它需要沿着垂直方向旋转到6个不同的方向(也就是60度拍一下),每个彩色相机都要拍高动态范围图像。当相机旋转时,3个深度相机持续拍摄数据,整合生成1280x1024的深度图像,与每幅彩色照片进行配准。每个全景图像是由18个彩色图片组成,中心点正好是拍摄人员的高度。

数据集链接:https://niessner.github.io/Matterport/#explore;

简介:Matterport3D,是一个大规模的RGB-D数据集。提供了表面重建、相机姿态以及二维和三维语义分割标注。Matterport3D具有的精确全局对准和全面的、多样的、覆盖整个建筑物的全景集,使得各种计算机视觉任务成为可能,包括keypoint matching、view overlap prediction、normal prediction、semantic segmentation, scene classification等;

Reference

[1] https://blog.csdn.net/weixin_40994913/article/details/83663270;

[2] 3D Object Detection for Autonomous Driving: A Survey,Pattern Recognition;

[3] https://gas.graviti.com/open-datasets?usedScene=Autonomous+Driving&from=cn&page=2;

本文仅做学术分享,如有侵权,请联系删文。